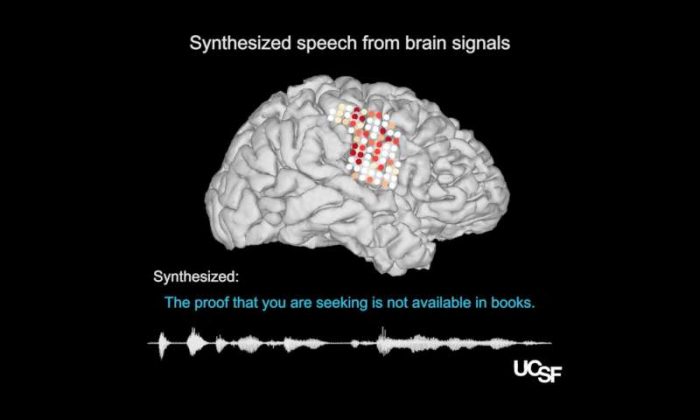

由加州大學舊金山分校(UC San Francisco)神經科學家創造的最先進腦機界面(A state-of-the-art brain-machine interface )可以通過使用大腦活動來控制虛擬聲道,產生自然合成的合成語音。電腦模擬細解讀嘴唇、下巴、舌頭和喉的運動,以產生流暢的語音。這項研究是由擁有完整言語能力的參與者進行,但該技術有朝一日可以為癱瘓和其他形式的神經損傷而失去說話能力的人恢復表達自己的能力。

中風(Stroke)、創傷性腦損傷(traumatic brain injury)和神經退行性疾病(eurodegenerative diseases),如帕金森病( Parkinson’s disease)、多發性硬化症(multiple sclerosis)和肌萎縮側索硬化症(amyotrophic lateral sclerosis)(ALS或Lou Gehrig’s disease)常常導致患者喪失說話能力。一些患有嚴重語言障礙的人會學習使用輔助設備,跟踪非常小的眼睛或面部肌肉運動,逐字拼出他們的想法。然而,用這樣的設備產生文本或合成語音非常吃力,又容易出錯,並且每分鐘允許最多10個字,與每分鐘100-150字的自然語音相比顯然太緩慢了。

2019年4月24日在Nature雜誌上描述醫學博士Edward Chang的實驗室開發了新系統,可以輸出一個人的聲音的合成版本,可以通過他們大腦的語音中心的活動來控制。作者說,未來這種方法不僅可以與嚴重言語殘疾的患者流暢溝通,還可以幫助他們表達情緒和個性和聲音中的音樂性(musicality)。

神經外科教授、加州大學舊金山分校威爾神經科學研究所成員Chang說:「這項研究首次示範出,我們可以根據個人的大腦活動,產生完整的口語句子。這是一個令人振奮的原理證據,是觸手可及的技術,我們應該能夠構建一種有臨床可行性的設備。」

虛擬聲樂(Virtual Vocal Tract)改進自然語音合成

該研究由語言科學家Gopala Anumanchipalli博士和生物工程研究生Josh Chartier領導。通過這項工作,Anumanchipalli博士和Chartier意識到,以前直接分析大腦活動語音,只取得有限的成功,因為這些大腦區域並不能直接代表語音的聲學特性,只是協調發聲時口和喉嚨所需的指令。

Anumanchipalli指出:「聲道運動與產生的語音之間的關係是一個複雜的關係。我們推斷,如果大腦中的這些語音中心是編碼動作而不是聲音,我們應該嘗試同時解讀這些信號。」

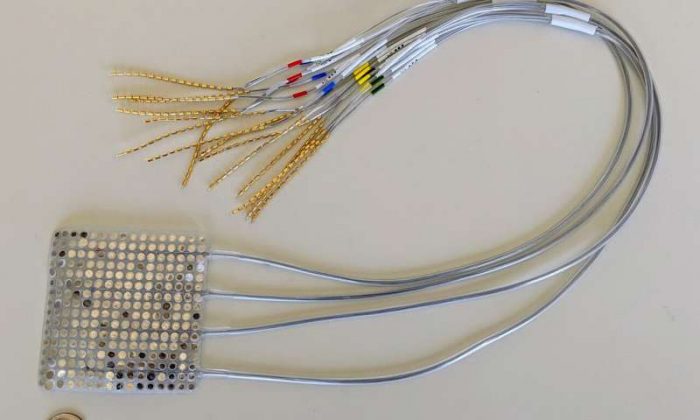

在他們的新研究中,Anumancipali和Chartier要求在加州大學舊金山分校癲癇中心(UCSF Epilepsy Cente)接受治療的五名有完整語言能力的志願者進行測試,在他們的大腦中暫時植入電極。志願者被要求大聲讀出數百個句子,而科學家則記錄了已知涉及言語產生的大腦區域的活動。

研究人員使用語言學原理對產生這些聲音所需的聲道運動進行逆向工程,以便能夠將大腦中的電活動模式與這將產生的聲音運動相匹配。為了測試合成語音的可懂度,科學家們通過亞馬遜Mechanical Turk 平台,邀請了數百人進行樣本轉錄。

轉錄人員在給予較短的單詞選擇列表時,理解得更好,就像護理人員為患者可能會說出的短語或要求做好準備一樣。轉錄人員準確地從25個選擇列表中識別出69%的合成詞,並且以完美的準確度轉錄了43%的句子。如果從更具挑戰性的50個單詞選擇,轉錄人員的整體準確率則降至47%,但他們仍能完整地理解21%的合成句子。

Chartier承認:「我們仍然有辦法完全模仿口語。 我們非常擅長合成較慢的語音,如「sh」和「z」,以及保持語音的節奏和語調,以及說話者的性別和身份,但是一些更短速的聲音,如「b」和「p」還不能完全分清。

人工智能、語言學和神經科學的進步

研究人員目前正在試驗更高密度的電極陣列和更先進的機器學習算法,他們希望這些算法能夠進一步改善合成語音。該技術的下一個主要測試一個不會說話的人能否學習使用該系統,在無法用他們自己的聲音進行訓練的前提下,看系統能否幫助他們表達任何內容。

該團隊的一位研究參與者的初步結果顯示,研究人員基於解剖學的系統可以解碼和合成來自參與者大腦活動的新句子,以及算法訓練的句子。即使研究人員提供了記錄大腦活動數據的算法,而一個參與者只是在沒有聲音的情況下說話,系統仍然能夠在說話者的聲音中產生可理解的合併版本的混合句子。

總之,這些研究結果顯示,由於神經功能障礙導致語言障礙的患者也可能學會控制系統,輸出以完整語音的人的聲音為模型的語音假體。

此外,「鋼鐵俠」Elon Musk也對這個領域頗感興趣,除了電動車和太空探索,他也早早於2016 年創立了腦機介面研發公司 Neuralink,與多位加州大學知名神經科學家合作,其短期目標是治癒嚴重的腦部疾病,如老年痴呆症和帕金森症,並且最終通過「與 AI 的融合」來增強大腦。

Chartier說:「肢體殘障者已經學會用大腦控制機器人肢體。我們希望有一天,有語言障礙的人能夠學會用這種腦控制的人工聲道再次說話。」

Anumanchipalli補充道:「我很自豪能夠將神經科學、語言學和機器學習的專業知識,幫助神經殘疾患者,那是一個重要里程碑。」

Source: Nature, Medicalxpress

Text by Medical Inspire